Outils pour utilisateurs

Panneau latéral

Table des matières

Les curiosités des années 2000

2600 series

Le Cisco 2600 Series est une gamme de routeurs modulaires créée dans les années 2000 par Cisco Systems, l'un des principaux fabricants de matériel réseau. Ces routeurs ont été largement utilisés dans les réseaux d'entreprises, les fournisseurs de services Internet et d'autres environnements nécessitant une connectivité réseau sécurisée et fiable.

Les routeurs de la série Cisco 2600 sont conçus pour offrir une grande flexibilité et extensibilité, grâce à leur architecture modulaire. Ils disposent de slots d'extension qui permettent l'ajout de modules supplémentaires pour prendre en charge différents types d'interfaces, tels que des interfaces LAN Ethernet (Local Area Network ou réseau local), des interfaces série, des interfaces RNIS (réseau numérique à intégration de services), des interfaces ADSL (Asymmetric Digital Subscriber Line ou liaison numérique asymétrique) et bien d'autres. Cette modularité permet aux utilisateurs de personnaliser leur configuration réseau en fonction de leurs besoins spécifiques.

Une interface d'un routeur est la connectique et les ports de connexion entre le routeur et le réseau ou les machines.

2800 series

Le Cisco 2800 Series est une gamme de routeurs modulaires créée dans les années 2000 par Cisco Systems, l'un des principaux fabricants de matériel réseau. Il s'agit de la gamme successeur de la série2600. Ces routeurs sont spécialement conçus pour les réseaux d'entreprises de taille moyenne à grande, offrant des performances élevées, une sécurité avancée et une modificabilité pour répondre aux besoins complexes de connectivité.

Ils embarquent toutes les fonctionnalités de la gamme 2600 avec en plus la VoIP (Voice over IP ou Voix sur IP) et des fonctions de sécurités supplémentaires. Ici encore, les routeurs de la série 2800 sont dotés de slots d'extension modulaires, permettant d'ajouter des modules d'interfaces supplémentaires pour répondre aux besoins spécifiques du réseau. Ces modules peuvent inclure des interfaces LAN (Local Area Network ou réseau local)), des interfaces WAN (Wide Area Network ou réseau étendu), des modules de sécurité, des modules de voix, etc. Cela permet une configuration personnalisée et adaptée selon les besoins spécifiques du réseau.

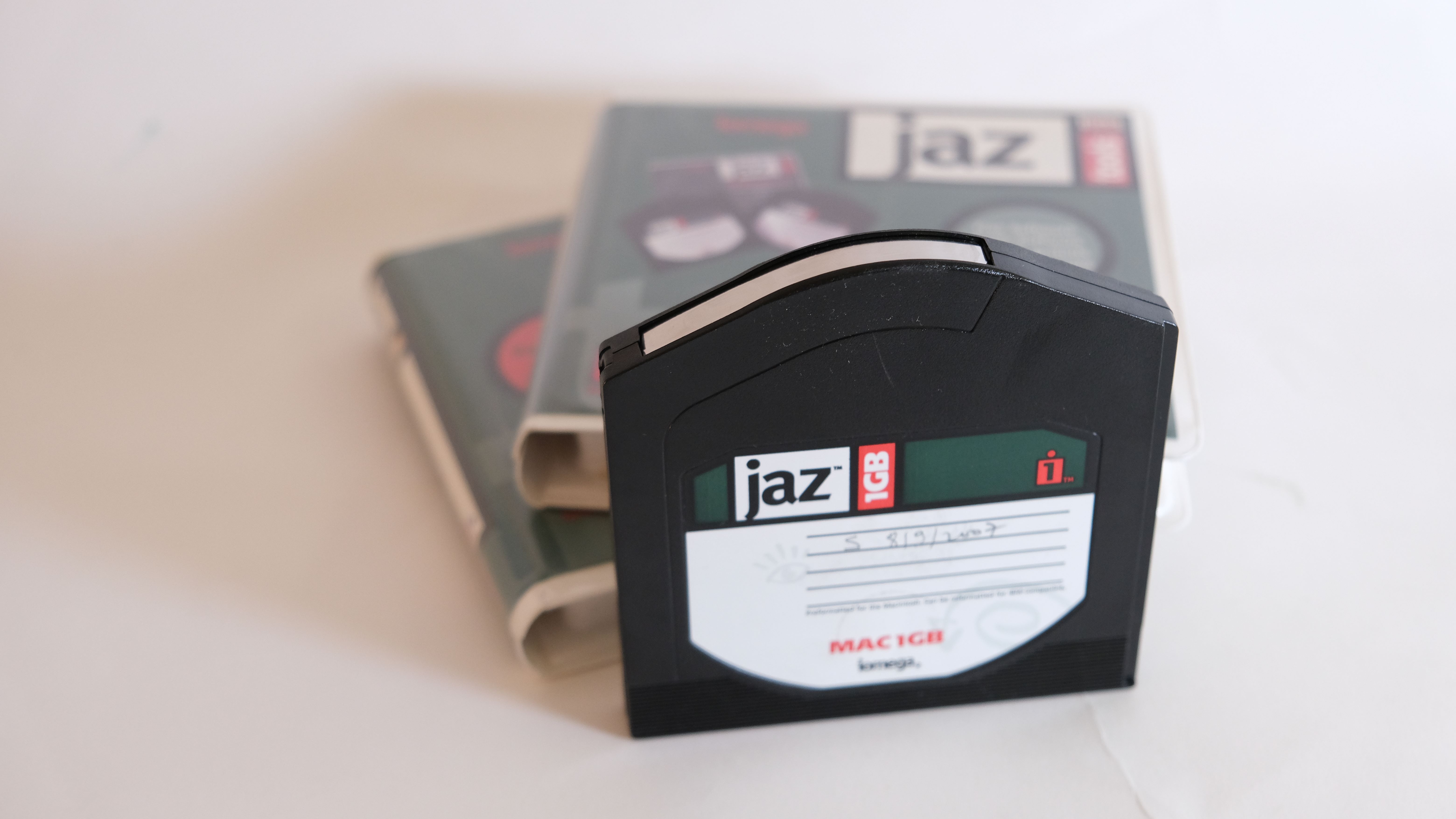

Bandes magnétiques

Les bandes magnétiques sont un support de stockage de données magnétiques largement utilisé dans le domaine de l'informatique. Elles se présentent sous la forme de rubans en plastique recouverts d'une couche magnétisable.

Elles sont principalement utilisées pour la sauvegarde et l'archivage des données. Elles offrent une solution économique pour stocker de grandes quantités de données sur une longue période. Les entreprises utilisent souvent des bandes magnétiques pour effectuer des sauvegardes régulières de leurs données critiques. On réalise souvent une sauvegarde par soir avec une sauvegarde complète hebdomadaire où on supprime tout et on réécrit tout. Cela permet d'accélérer la récupération, car elle nécessite de parcourir la totalité de la bande ce qui prend du temps.

Il existe plusieurs types de bandes magnétiques, notamment les bandes magnétiques linéaires (LTO), les bandes DLT(Digital Linear Tape), les bandes DAT (Digital Audio Tape) et les bandes de sauvegarde à haut débit. Chaque type de bande magnétique a ses propres caractéristiques en termes de capacité, de vitesse de transfert et de compatibilité.

Les bandes magnétiques continuent d'être utilisées dans certains contextes, notamment pour la sauvegarde et l'archivage à long terme des données. Cependant, avec les avancées technologiques et l'émergence de nouvelles solutions de stockage, leur utilisation est devenue moins répandue dans les environnements informatiques grand public.

Disque Optique

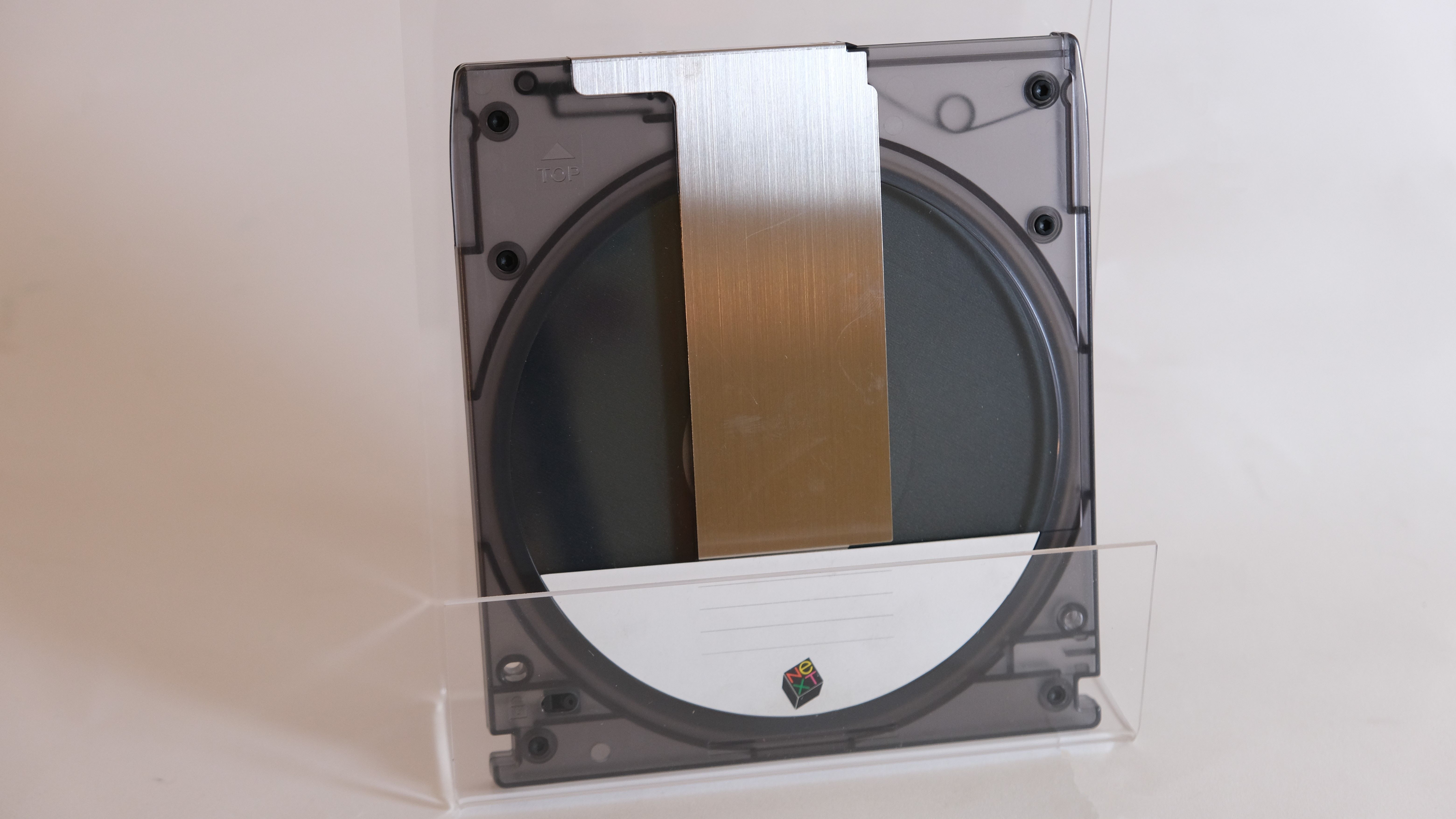

Afin de pallier au problème d'écriture unique les disques optiques, on a inventé le disque magnéto-optique ou CD-MO en 1985. Il s'agit d'un disque optique sans sillons. En effet, selon la polarisation du champ magnétique sur un certain point les lecteurs peuvent déterminer grâce à un laser s'il s'agit du bit 1 ou 0. Pour l'écriture, le laser chauffe un point sur le disque et on lui applique un champ magnétique pour le polariser dans un sens (0) ou dans l'autre (1). Les données ne peuvent être modifiées que si le disque est chauffé jusqu'au point de Curie, ce qui entraine la perte de l'aimantation du disque le rendant modifiable. Ainsi les disques magnéto-optiques étaient bien plus fiables que les supports magnétiques comme les cassettes ou les disques durs. Ils étaient en particulier immunisés à la destruction des données que subissaient les supports magnétiques lorsqu'ils étaient soumis à un champ magnétique. La durée d'archivage des données, si les supports sont conservés à une température stable, peut aller jusqu’à 30 ans, ce qui en fait une bonne alternative aux bandes magnétiques. Ils étaient en particulier utilisés chez NeXT pour la NeXTstation et NeXTSTEP.

L'histoire des disques optiques remonte aux années 1960, lorsque des chercheurs ont commencé à explorer de nouvelles méthodes de stockage de données à l'aide de la technologie optique. L'idée était de créer un support de stockage non volatile capable de stocker une grande quantité d'informations de manière compacte et durable.

Le premier disque optique, connu sous le nom de LaserDisc, a été développé en 1970 par Philips et MCA (Music Corporation of America). Le LaserDisc était un disque de 12 pouces (30 cm) de diamètre qui utilisait un faisceau laser pour lire les données gravées sur sa surface sous forme de sillons analogiques. Il a été principalement utilisé pour la distribution de films et de programmes vidéo, bien qu'il n'ait pas connu un succès massif en raison de sa taille et de son coût élevé.

Le Compact Disc (CD) a été introduit en 1982 par Sony et Philips. Il utilisait un laser pour lire des données numériques gravées sous forme de petits creux sur la surface du disque, permettant ainsi une meilleure qualité audio que les supports analogiques existants à l'époque. Le CD a révolutionné l'industrie de la musique en offrant une meilleure qualité sonore et une durée de vie plus longue que les disques vinyles ou les cassettes audio.

Dans les années 1990, le Digital Versatile Disc (DVD) a été développé comme une évolution du CD, offrant une capacité de stockage beaucoup plus élevée et la possibilité de stocker des vidéos de haute qualité. Le DVD est devenu le format standard pour la distribution de films et de programmes vidéo, remplaçant rapidement les cassettes VHS.

Au début des années 2000, un autre type de disque optique, le Blu-ray, a été développé. Le Blu-ray offre une capacité de stockage encore plus élevée que le DVD et permet de stocker des vidéos haute définition (HD) et ultra haute définition (UHD). Il est devenu le format de choix pour les amateurs de cinéma et les passionnés de jeux vidéo.

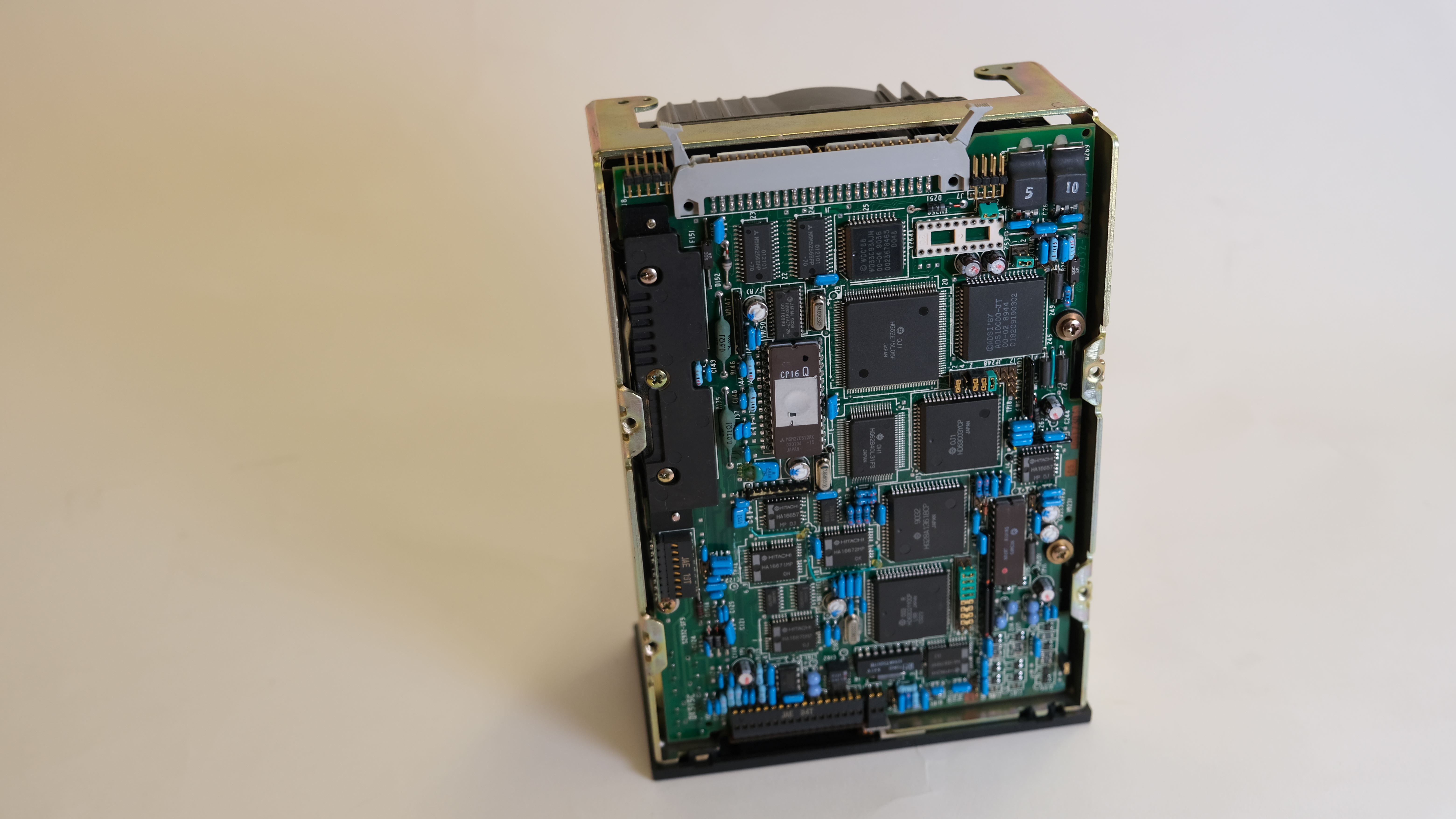

Disques Durs

Un disque dur est composé de plusieurs plateaux magnétiques montés sur un axe central. Chaque plateau possède deux surfaces magnétiques où les données sont stockées. Au-dessus de chaque surface se trouve une tête de lecture/écriture (TLE) montée sur un bras mobile. Les TLE lisent et écrivent les données en générant un champ magnétique pour changer l'orientation magnétique des grains sur le plateau. Les pistes concentriques sur chaque surface du plateau stockent les données, divisées en secteurs de base de 512 octets. Lorsqu'on souhaite accéder aux données, le bras déplace les TLE vers la piste appropriée pour la lecture ou l'écriture. Les disques durs utilisent ce processus pour stocker et récupérer les données rapidement et efficacement.

L'histoire des disques durs remonte aux années 1950, lorsque les premières recherches sur le stockage magnétique ont été entreprises par plusieurs entreprises, dont IBM. En 1956, IBM a commercialisé le RAMAC 305, considéré comme le premier disque dur de l'histoire. Il était constitué de 50 plateaux magnétiques rotatifs de 24 pouces de diamètre et pouvait stocker jusqu'à 5 mégaoctets (Mo) de données, un exploit technologique remarquable à l'époque.

Au fil des décennies, les disques durs ont connu une évolution constante en termes de capacité, de taille et de performances. Dans les années 1960 et 1970, les disques durs étaient volumineux et coûteux, principalement utilisés dans les grands systèmes informatiques et les centres de données.

Au cours des années 1980, les disques durs ont commencé à être utilisés dans les ordinateurs personnels, ce qui les a rendus plus accessibles aux utilisateurs individuels. Les capacités de stockage ont progressivement augmenté pour atteindre des mégaoctets, puis des gigaoctets dans les années 1990.

Au tournant du siècle, les disques durs ont continué à évoluer rapidement, avec des capacités de stockage qui ont atteint des téraoctets. Les disques durs sont devenus plus petits, plus rapides et moins chers, ce qui les a rendus omniprésents dans les ordinateurs portables, les ordinateurs de bureau, les serveurs et autres dispositifs de stockage.

Cependant, avec l'avènement des technologies de mémoire flash, tels que les SSD (Solid State Drive), les disques durs ont commencé à faire face à une concurrence sérieuse. Les SSD offrent des performances plus rapides, une consommation d'énergie réduite et une plus grande durabilité, ce qui les rend idéaux pour les appareils mobiles et les ordinateurs haut de gamme.

Malgré cela, les disques durs continuent d'être largement utilisés dans de nombreux domaines, notamment le stockage de données à grande échelle, les centres de données, la surveillance vidéo, les systèmes de sauvegarde, etc. En raison de leur coût par gigaoctet inférieur et de leur capacité de stockage élevée, les disques durs restent une solution privilégiée pour le stockage à grande échelle et les applications nécessitant des capacités de stockage massives.

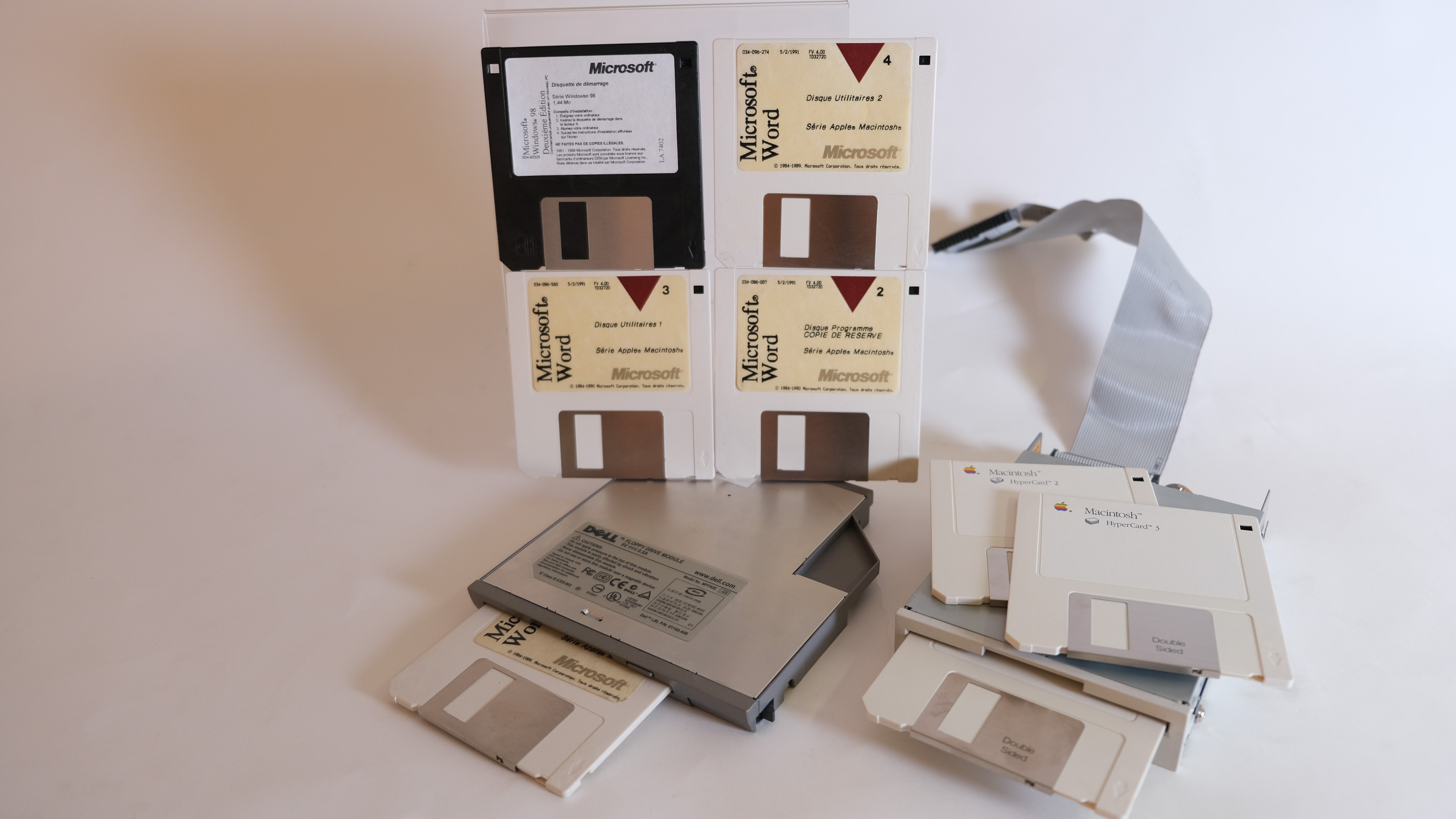

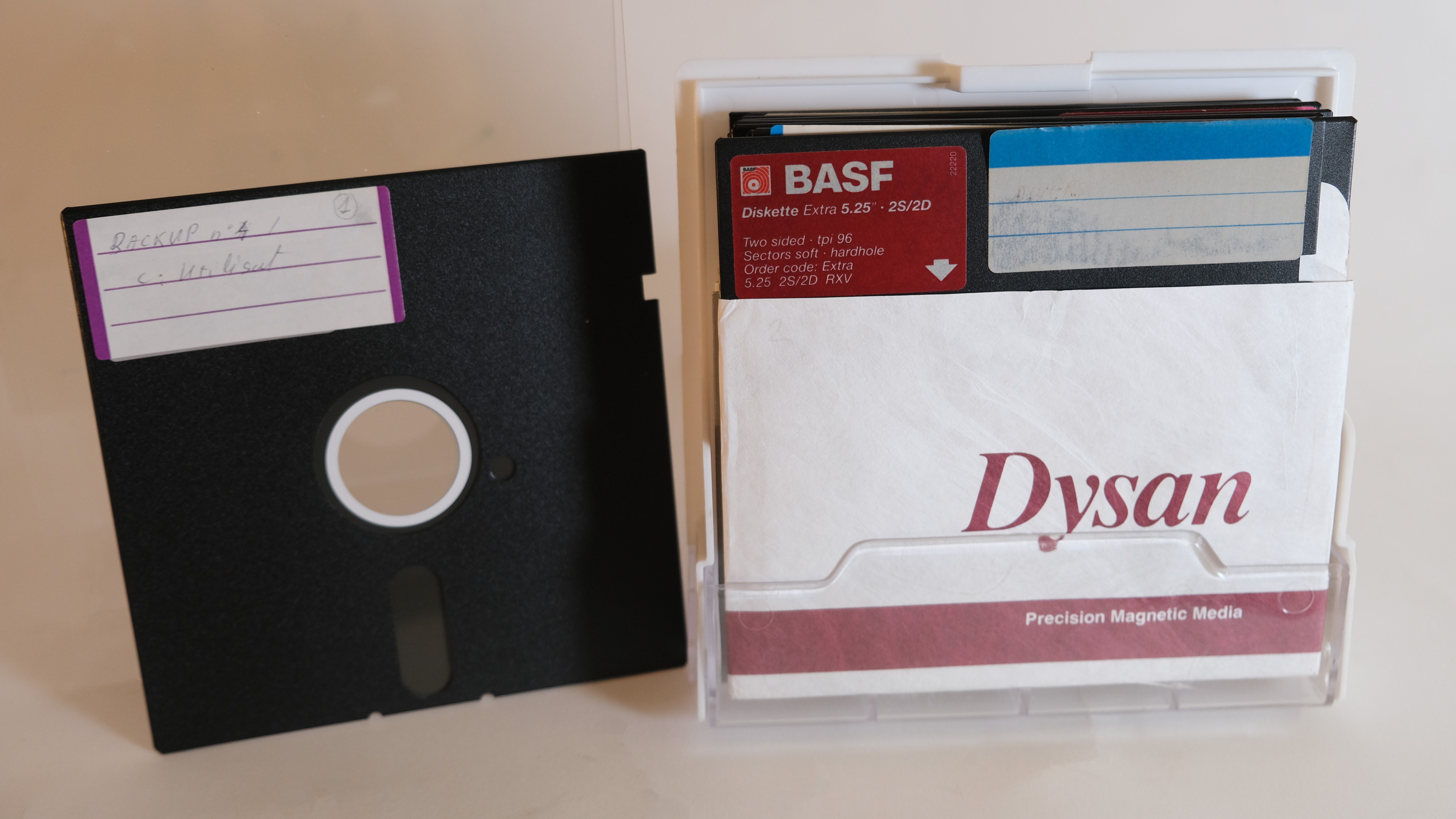

Disquettes

Le fonctionnement des disquettes est basé sur la technologie d'enregistrement magnétique, similaire à celle des disques durs. Chaque disquette est constituée d'un mince disque en plastique recouvert d'une couche magnétique. Pour écrire des données sur la disquette, une tête de lecture/écriture magnétique (TLE) envoie un courant électrique à travers la tête pour créer des changements magnétiques sur la surface du disque. Pour lire les données, la TLE détecte les changements magnétiques déjà présents sur la surface du disque.

L'accès aux données sur une disquette se fait séquentiellement, ce qui signifie que l'ordinateur doit parcourir les pistes une par une pour atteindre l'information souhaitée. Cela rendait le temps d'accès aux données relativement lent par rapport à d'autres supports de stockage plus modernes.

L'histoire des disquettes remonte aux années 1970. Elles ont été développées comme une solution portable pour le stockage de données, permettant aux utilisateurs de transférer des informations d'un ordinateur à un autre.

Les premières disquettes étaient généralement de 8 pouces (environ 20 cm) de diamètre et avaient une capacité de stockage relativement faible, de l'ordre de quelques kilooctets (Ko). Elles étaient utilisées dans les premiers ordinateurs personnels et systèmes informatiques. Cependant, en raison de leur taille et de leur coût élevé, les disquettes de 8 pouces ont été remplacées par des disquettes plus petites.

Dans les années 1980, les disquettes de 5,25 pouces (environ 13 cm) sont devenues populaires. Elles avaient une capacité de stockage allant jusqu'à 1,2 mégaoctets (Mo). Les disquettes de 5,25 pouces étaient couramment utilisées dans les ordinateurs personnels de l'époque pour le stockage de fichiers, de logiciels et de jeux.

Dans les années 1990, les disquettes de 3,5 pouces (environ 9 cm) sont devenues le format standard. Elles avaient une capacité de stockage de 1,4 mégaoctets (Mo) et étaient largement utilisées dans les ordinateurs portables et de bureau. Les disquettes de 3,5 pouces étaient faciles à transporter et ont été utilisées pendant de nombreuses années comme moyen de transfert de fichiers et de sauvegarde.

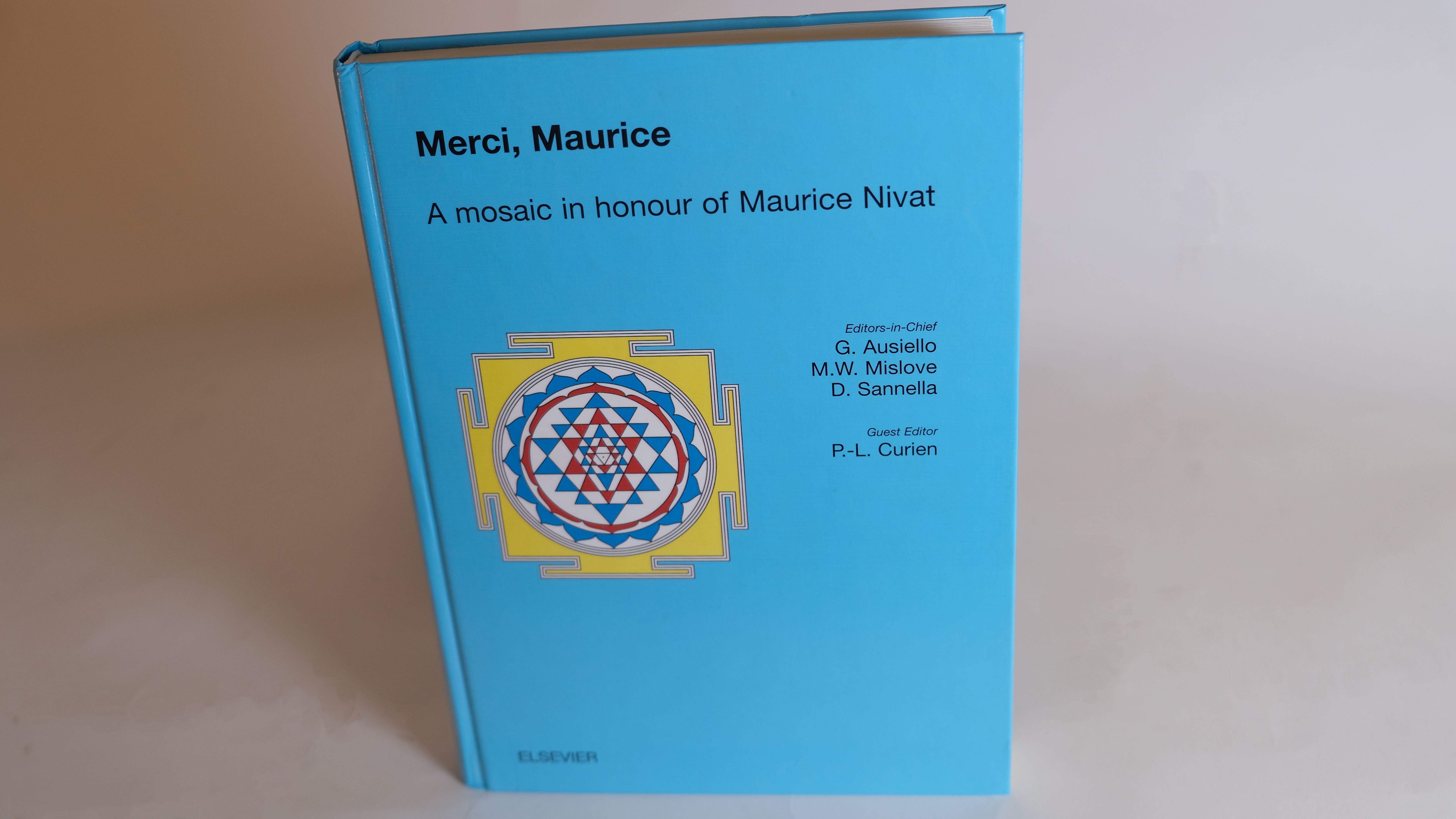

Merci, Maurice

Avec la publication de cet ouvrage, la communauté de l'informatique théorique souhaite célébrer la carrière et les prouesses de Maurice Nivat suite à son départ à la retraite en 2001. Elle souhaite par ailleurs exprimer sa plus grande gratitude pour sa contribution et tous ses accomplissements qui ont tant fait pour le développement de cette discipline.

Tout au long de sa carrière, Maurice Nivat a été l'une des figures les plus influentes dans l'histoire de l'informatique théorique. Sa notoriété découle de ses nombreuses recherches fondamentales dans une grande variété de sujets ainsi que la qualité de ses enseignement et de son rôle dans la création et la reconnaissance de l'informatique théorique comme une science à part et respectée des autres disciplines plus anciennes.

Une grande partie de ces résultats a été obtenue grâce à l'énergie et à la vision intellectuelle de Maurice Nivat en tant que fondateur et rédacteur en chef de “Theoretical Computer Science”, la revue qu'il a dirigée au cours des vingt-cinq dernières années et qui, depuis sa création en 1975, s'est imposée comme une référence dans le domaine de l'informatique et de la recherche.

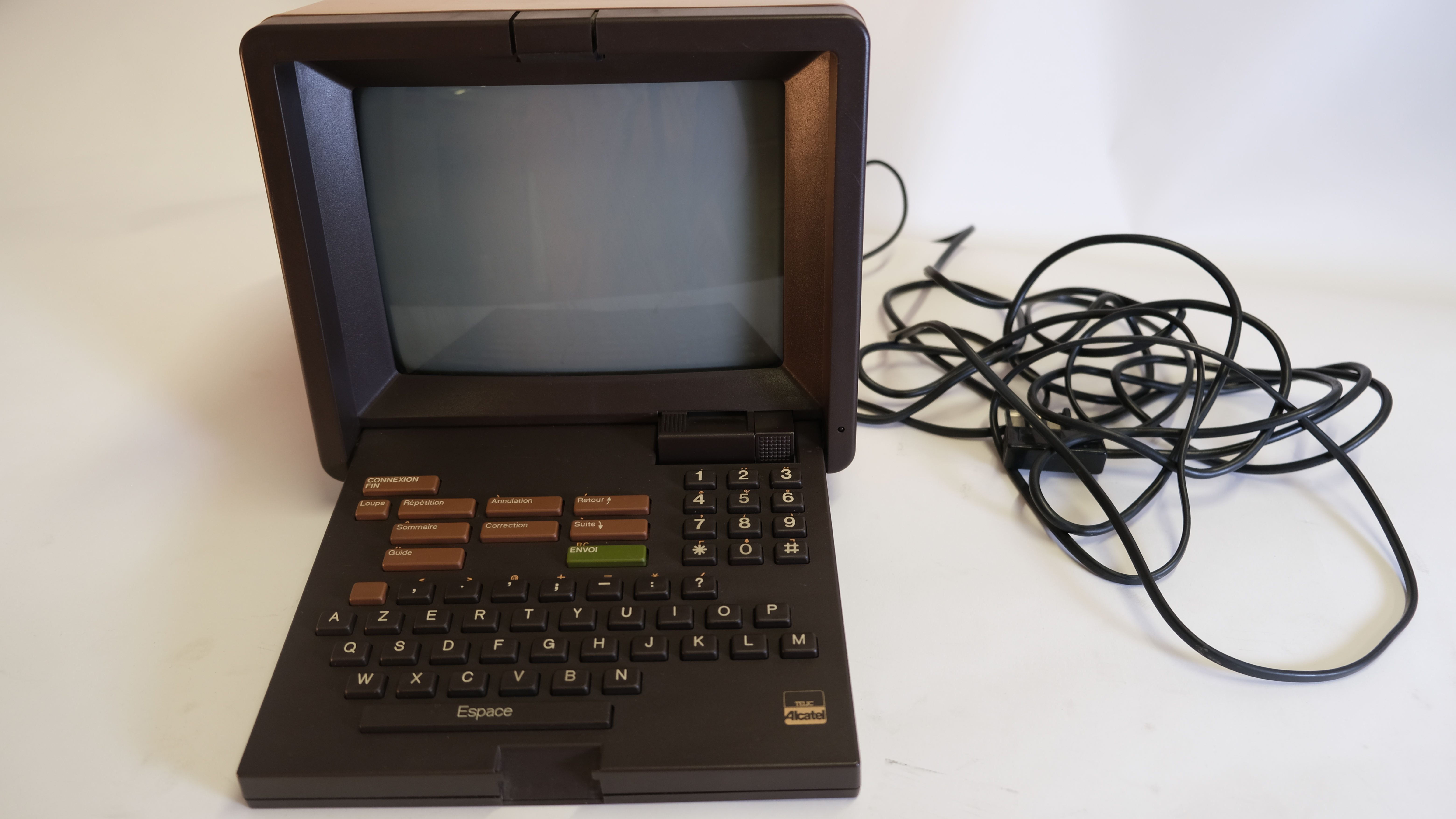

Minitel

Le Minitel (ou Médium interactif par numérisation d'information téléphonique) est un petit terminal informatique passif destiné à la seule connexion au service Télétel français de Vidéotex. Son fournisseur standard pour les PTT, développeur du réseau à partir de technologies mises au point par le CNET, était l'entreprise Alcatel. Cependant, plusieurs autres fournisseurs ont proposé des équipements spécifiques pour une clientèle plus exigeante comme Matra ou Radiotechnique de Phillips.

Les serveurs (n° de téléphone) auxquels les opérateurs se connectaient avec un Minitel étaient appelés des services Télétel. Ces appareils étaient des passerelles vers le réseau du même nom basé sur Transpac, qui permettait de mettre en relation les Minitels avec les serveurs des prestataires de service. L'utilisateur pouvait donc se connecter par l'intermédiaire de clavier à divers services télématiques publics ou privés. L'application la plus connue était l'annuaire électronique (code 3611). On peut citer aussi la météo nationale, les horaires SNCF. Le réseau Minitel fut pendant plusieurs années le prototype et le plus important réseau mondial de commerce électronique

Selon France Telecom, en février 2009 le réseau de Minitel comptait 10 millions de connexions mensuelles (4 000 codes de services Vidéotex) dont 1 million sur le 3611 annuaire électronique. On comptait encore 2 millions d'utilisateurs en 2010. La fermeture du service a été reportée au 30 juin 2012.

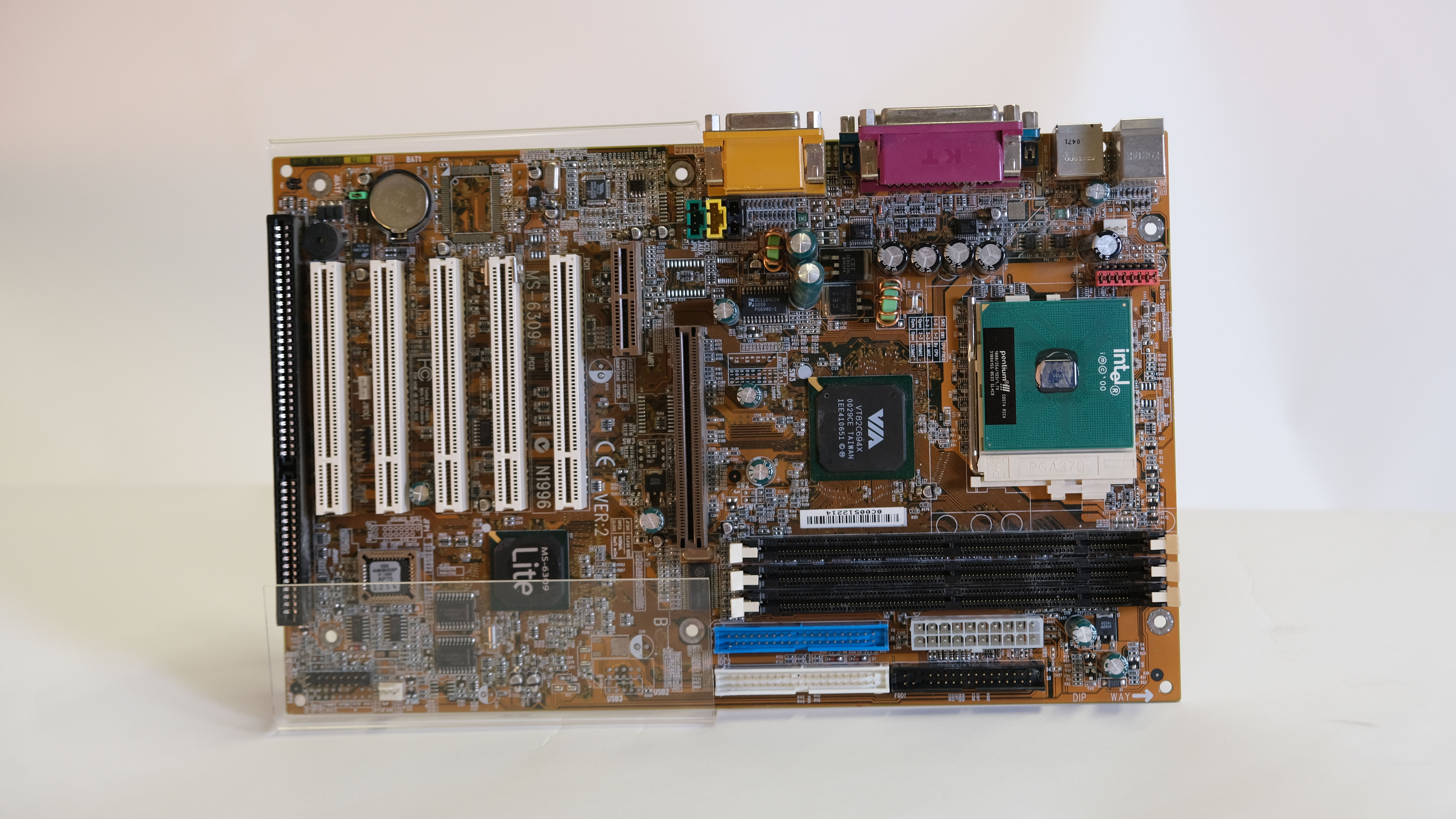

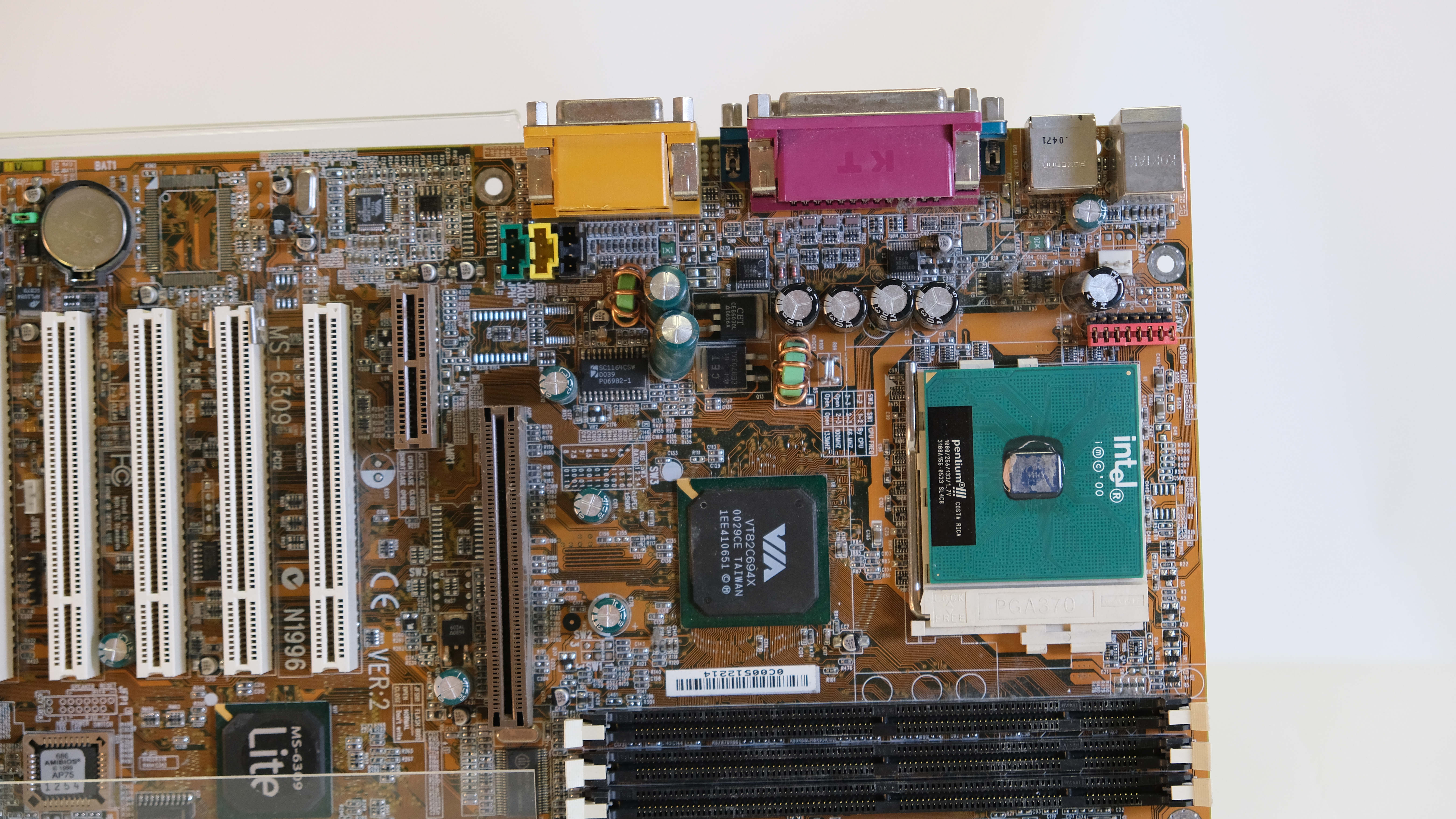

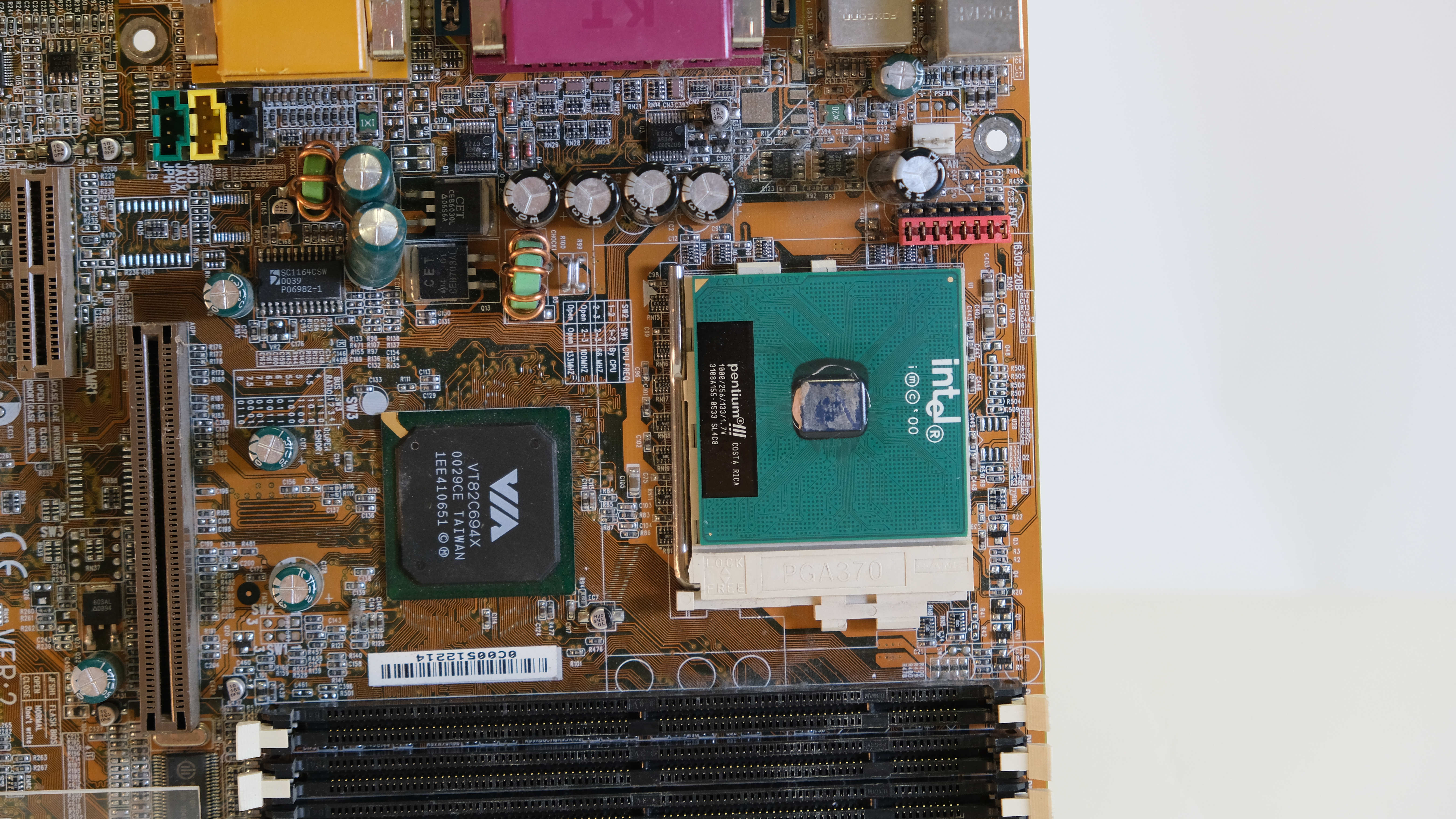

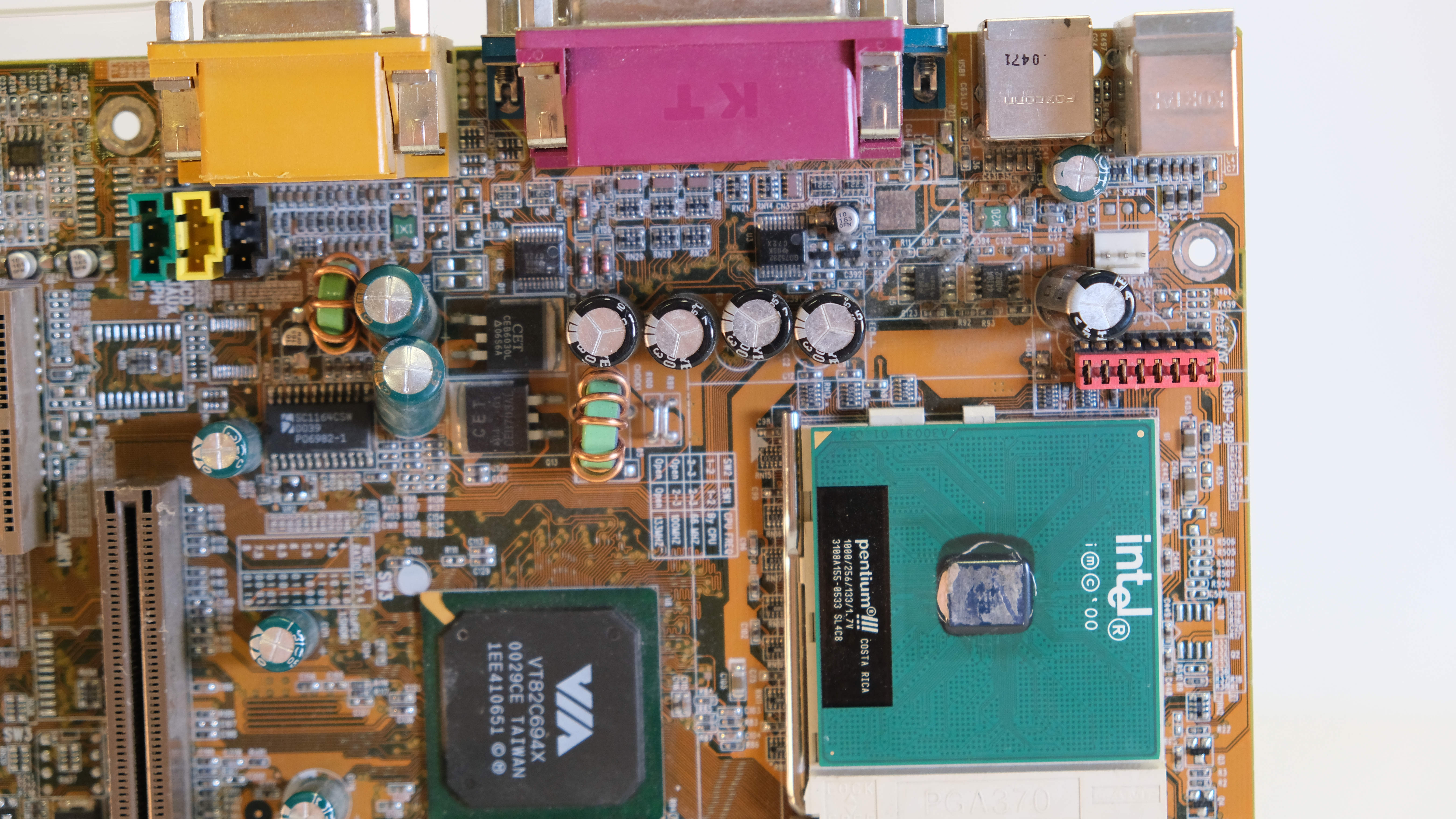

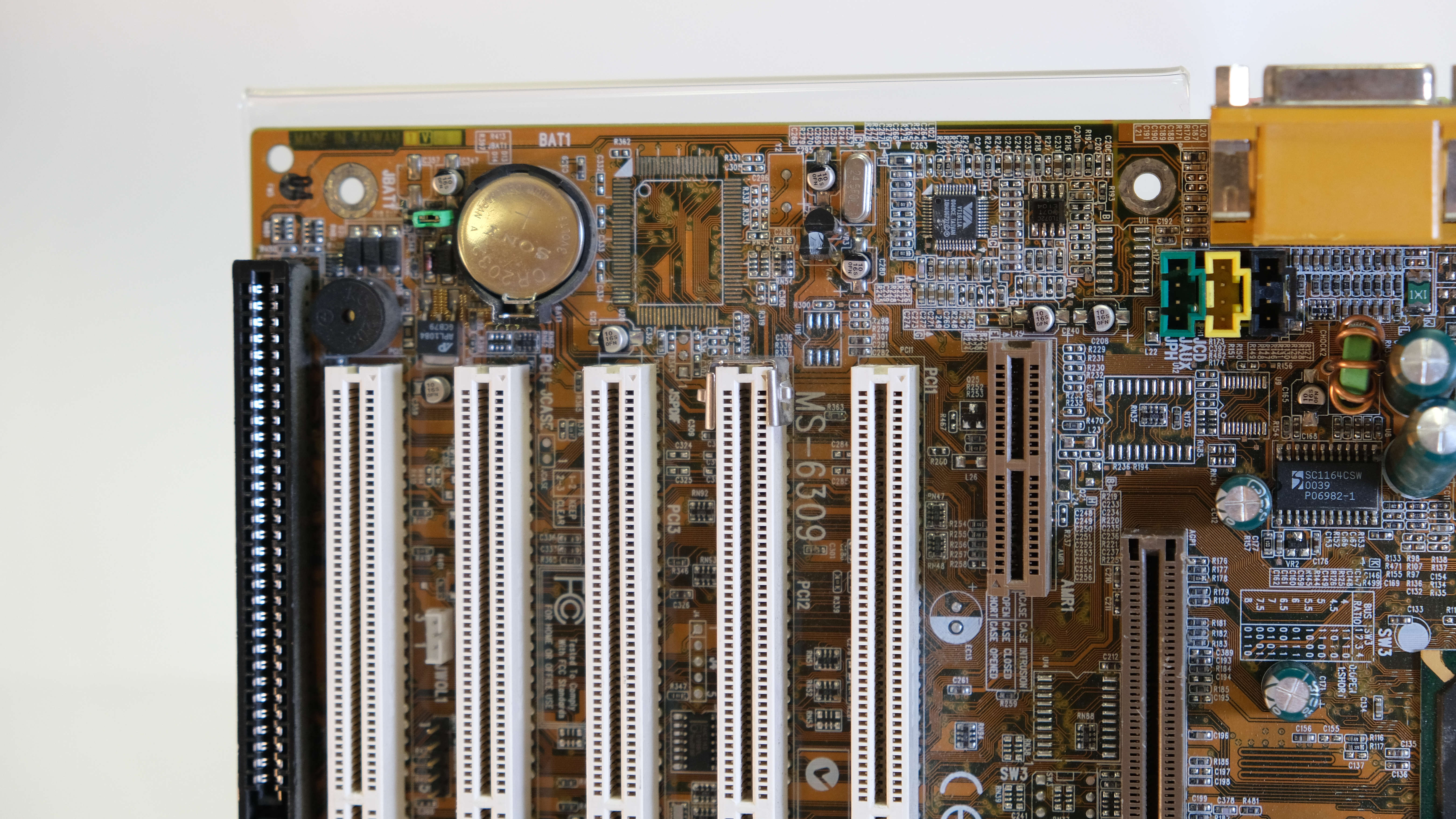

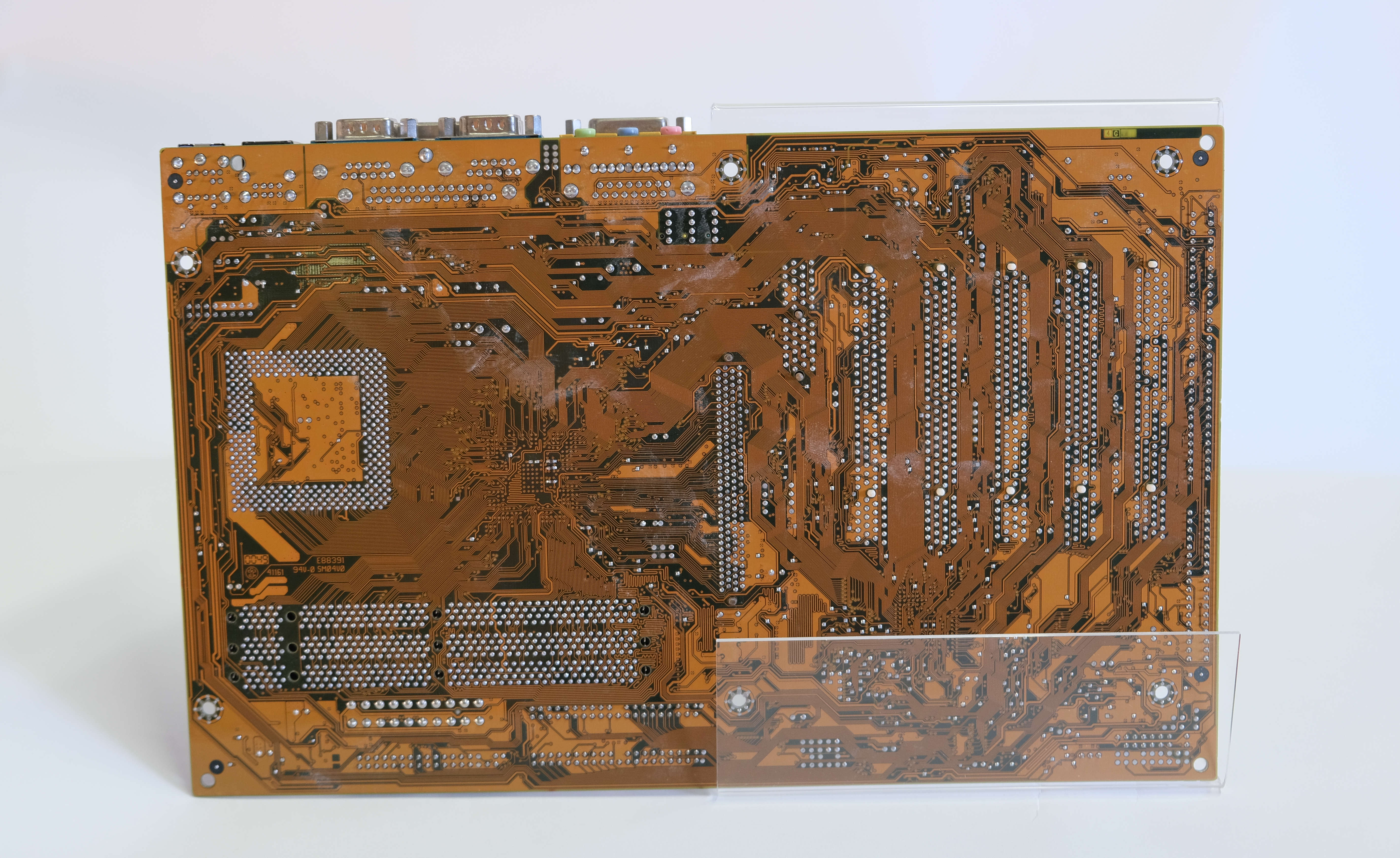

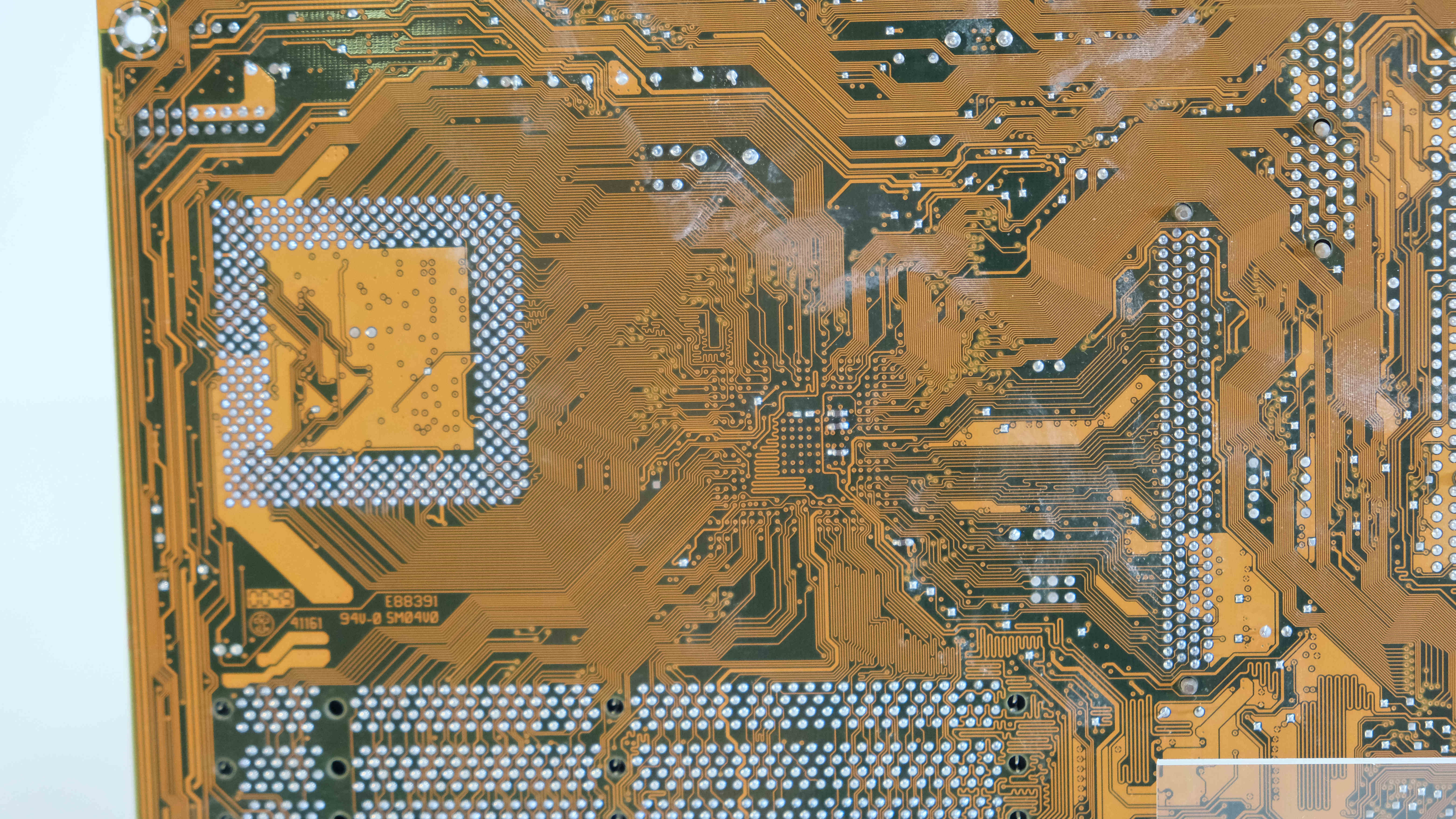

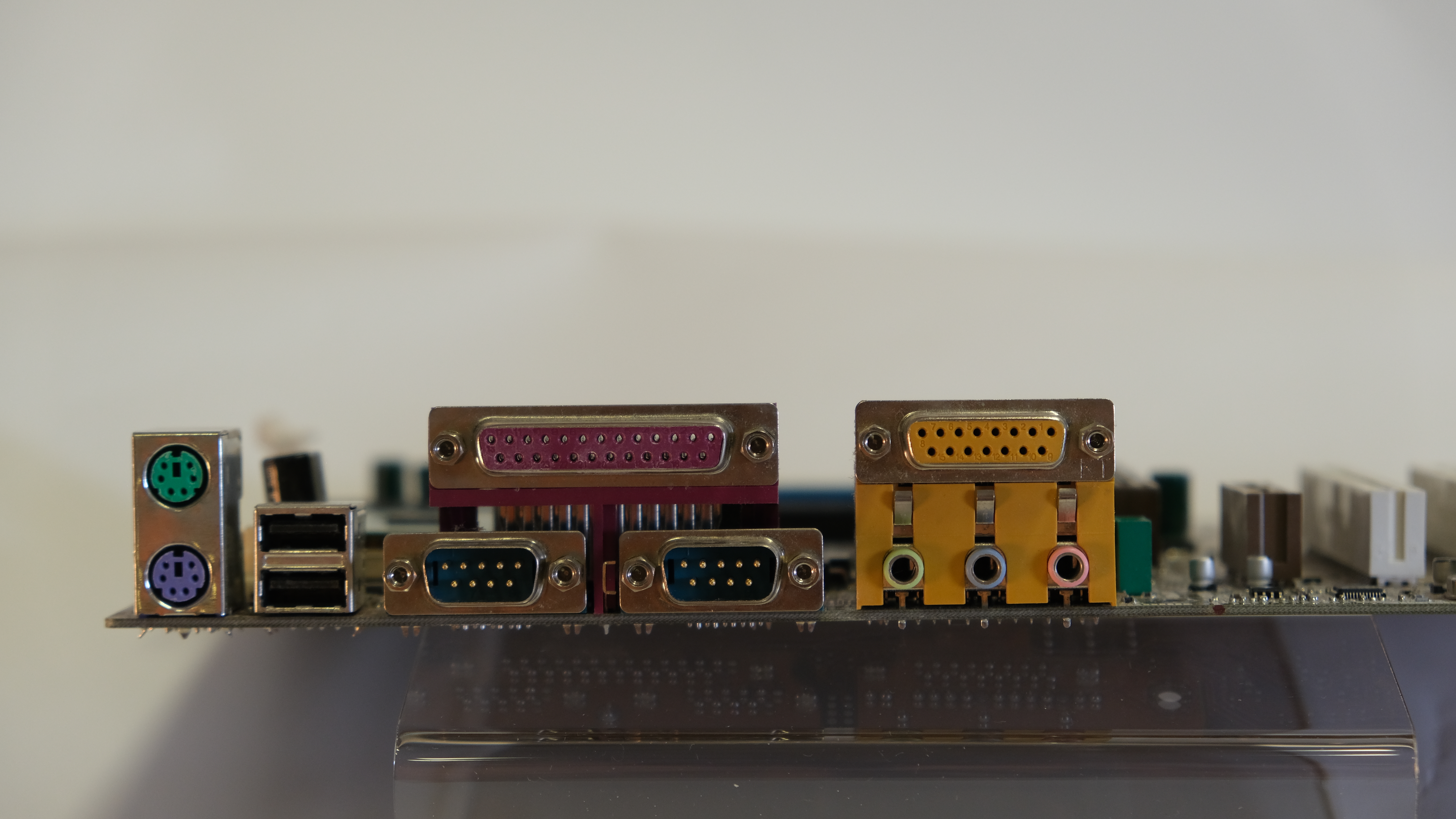

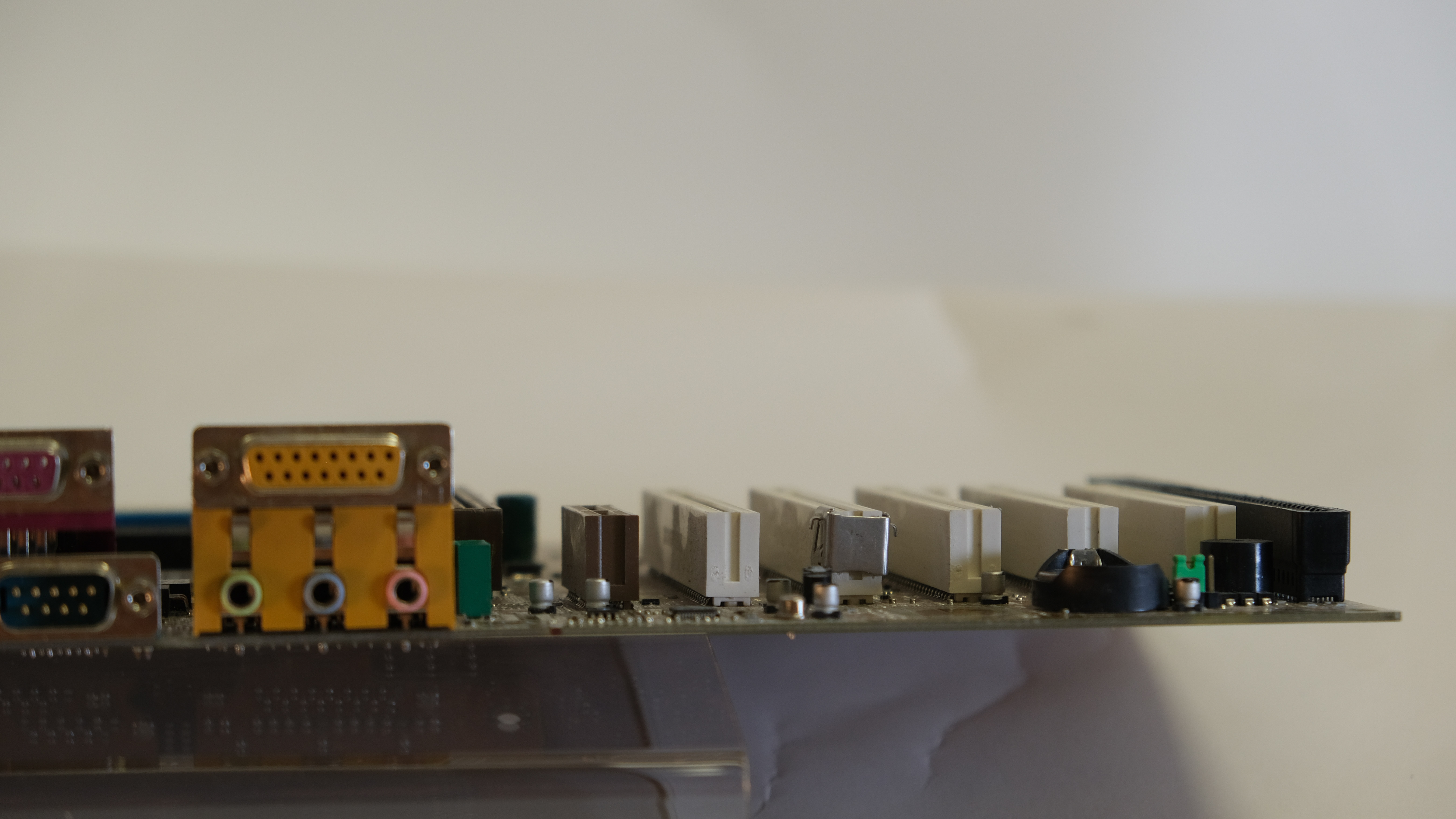

MS-6309

La MSI MS-6309 est une carte mère fabriquée par MSI (Micro-Star International), une société taïwanaise spécialisée dans la fabrication de matériel informatique. La MSI MS-6309 était une carte mère destinée aux ordinateurs de bureau et a été commercialisée à la fin des années 1990. Elle est destinée aux processeurs au format Socket 370 comme les Pentium III FC-PGA, Celeron PPGA et Cyrix III.

Sur la carte, on retrouve le système D-LED spécifique aux cartes mères MSI. Ce système composé de 4 LED bicolores suit, par un code de couleurs, la procédure de démarrage du système qui vous permettra lors d'un éventuel blocage de déterminer d'où provient la panne et donc d'éliminer un temps de recherche fastidieux.

Power Mac G4

Le Power Mac G4 est une ligne d'ordinateurs de bureau conçue et fabriquée par Apple. Il a été lancé en 1999 en tant que successeur du Power Mac G3 et a été commercialisé jusqu'en 2004. Le Power Mac G4 était réputé pour sa puissance, sa flexibilité et sa capacité à gérer des tâches exigeantes, notamment dans le domaine de la création graphique et du traitement multimédia.

Il possédait le même châssis que le dernier modèle du Power Macintosh G3, le Power Macintosh G3 (Bleu et Blanc). D'abord équipé de processeurs PowerPC G4 cadencés à 500 MHz et plus (aujourd'hui on est de l'ordre du GHz), Apple a décidé de réduire la cadence des processeurs sans changer le prix des machines ce qui a créé une polémique. Cela était dû à l'incapacité de Motorola de produire les processeurs.

ProCurve 10Base-T 12M/24M

Les routeurs ProCurve 10Base-T 12M de HP étaient un moyen simple et peu coûteux de construire un nouveau réseau ou d'étendre un réseau existant. Ils possèdent douze ports 10BASE-T pour la version 12M et vingt-quatre ports pour la version 24M. Il est possible d'ajouter des modules afin d'adapter les commutateurs aux besoins de l'entreprise.

Ils embarquent un gestionnaire capable de détecter de manière proactive les problèmes de réseau courants, notamment les cartes d'interface réseau et les câbles défectueux ainsi qu'une topologie de réseau incorrecte, et les corrige si possible. Ils disposent également de capacités de gestion à distance afin de maintenir des performances optimales. Les fonctions de gestion avancées comprennent la prise en charge complète de SNMP, RMON, la surveillance du trafic et l'isolation des pannes. Il existe également une sécurité complète pour les groupes de travail, y compris la prévention des intrusions, la désactivation automatique des ports et un système d'alarme.

HP ProCurve était la branche réseau de HP de 1998 à 2010 et était associée aux produits qu'elle vendait. Le nom de la division a été changé en HP Networking en septembre 2010 après le rachat de 3Com par HP.

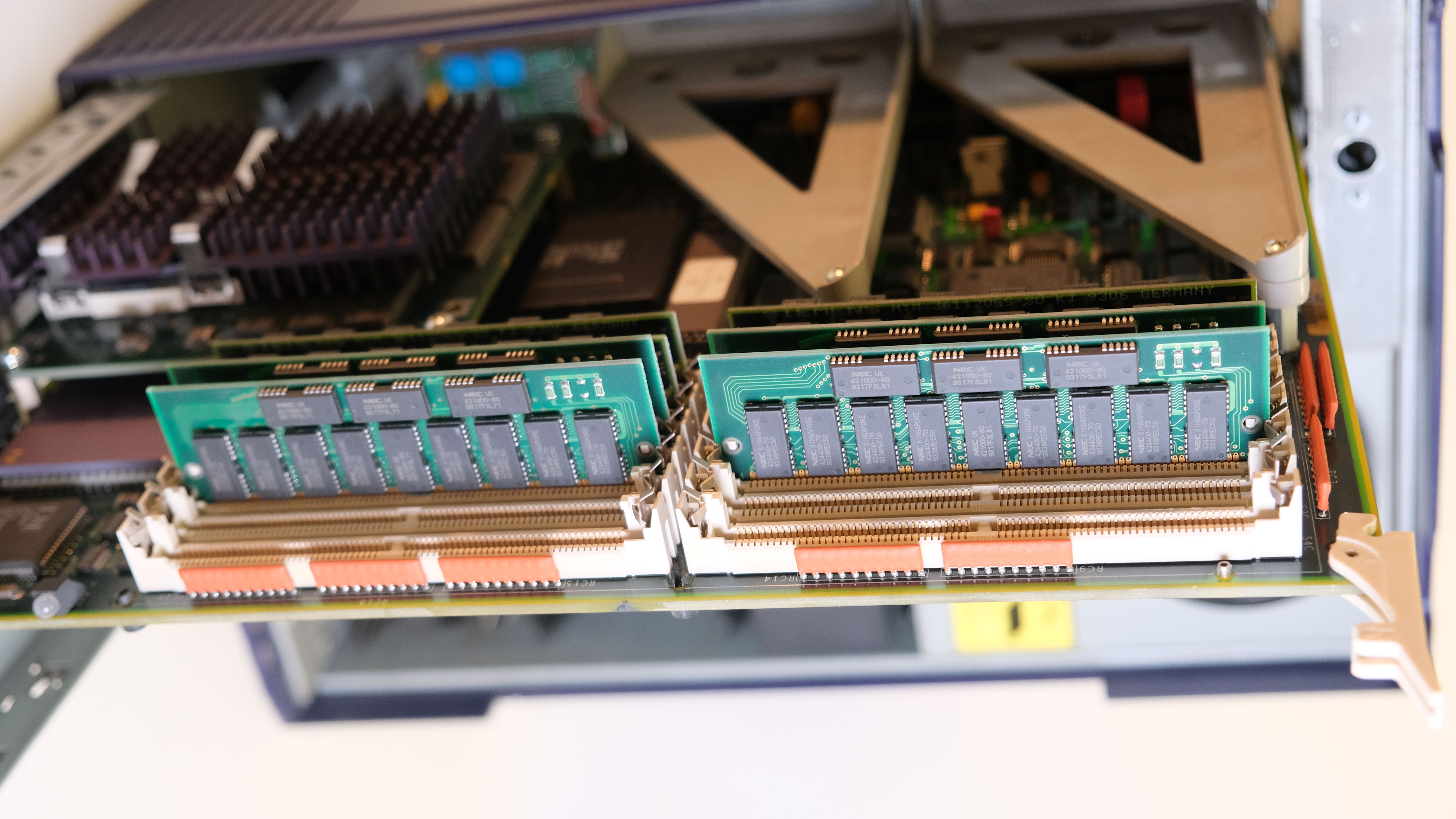

RAM

Dans les années 1970, la RAM (Random Access Memory ou Mémoire à Accès Aléatoire) à semi-conducteurs a fait son apparition. Les premières puces de mémoire RAM à semi-conducteurs étaient composées de transistors individuels et de condensateurs, ce qui les rendait relativement volumineuses et coûteuses. Cependant, au fil des avancées technologiques, les puces de mémoire sont devenues plus petites et moins chères.

L'une des avancées majeures dans l'histoire de la RAM a été l'introduction de la mémoire DRAM (Dynamic Random Access Memory) dans les années 1970. La DRAM utilise des condensateurs pour stocker les données, ce qui permet d'obtenir une plus grande densité de stockage par rapport aux mémoires statiques à semi-conducteurs précédentes. La DRAM est devenue la forme de RAM la plus couramment utilisée dans les ordinateurs personnels et autres appareils électroniques. La SRAM est plus rapide que la DRAM car elle n'a pas besoin de se rafraîchir constamment pour conserver les données. Cependant, la SRAM est plus coûteuse et moins dense que la DRAM, elle est donc généralement utilisée dans des applications où la vitesse est critique, comme les caches de processeur.

Dans les années 1980 et 1990, les ordinateurs personnels sont devenus de plus en plus populaires, et la demande de RAM a explosé. Les fabricants de semi-conducteurs ont continué à innover pour augmenter la capacité et la vitesse de la RAM tout en réduisant sa taille et son coût. La SDRAM (Synchronous Dynamic Random Access Memory) est devenue le standard de facto dans les années 1990, offrant des améliorations significatives en termes de vitesse de transfert de données.

Au fil des années, la technologie de la RAM a continué à évoluer pour augmenter la capacité, la vitesse et l'efficacité énergétique. De nos jours, les ordinateurs utilisent principalement la SDRAM pour leur mémoire principale, tandis que la SRAM est utilisée dans des applications où la vitesse est primordiale, comme les caches et les mémoires embarquées.

Sun Ray 2

Le Sun Ray 2 est un client léger conçu et fabriqué par Sun Microsystems (plus tard acquis par Oracle Corporation). Il a été lancé en 2007 et faisait partie de la gamme de produits Sun Ray, qui proposait des solutions de virtualisation et de postes de travail déportés. La ligne de production Ray a été lancée en 1999 et terminée en 2014 par Oracle

Un client léger nécessite un serveur pour leur bon fonctionnement, même si il est suffisamment équipé pour être un minimum autonome. Ce principe de client léger n'est pas nouveau. en effet au début de l'informatique, il y avait souvent de grosses machines performantes qui s'occupait de faire le traitement et d'autres qui étaient destinées aux clients. Nous pouvons retrouver ce principe encore aujourd'hui avec les supercalculateurs. Néanmoins, dans les années 1990, avec l'augmentation fulgurante de la puissance des ordinateurs, les postes client n'avait plus besoin de se connecter pour travailler. Le réseau ne servait plus alors qu'à stocker des données, mais pas à apporter une puissance permettant un traitement. Cependant, le coup de maintenance de ces machines étaient assez énorme entre un matériel défectueux et des systèmes d'exploitation non fiables. Il a donc été choisi de revenir sur des machines plus simples, plus fiable et moins chères.

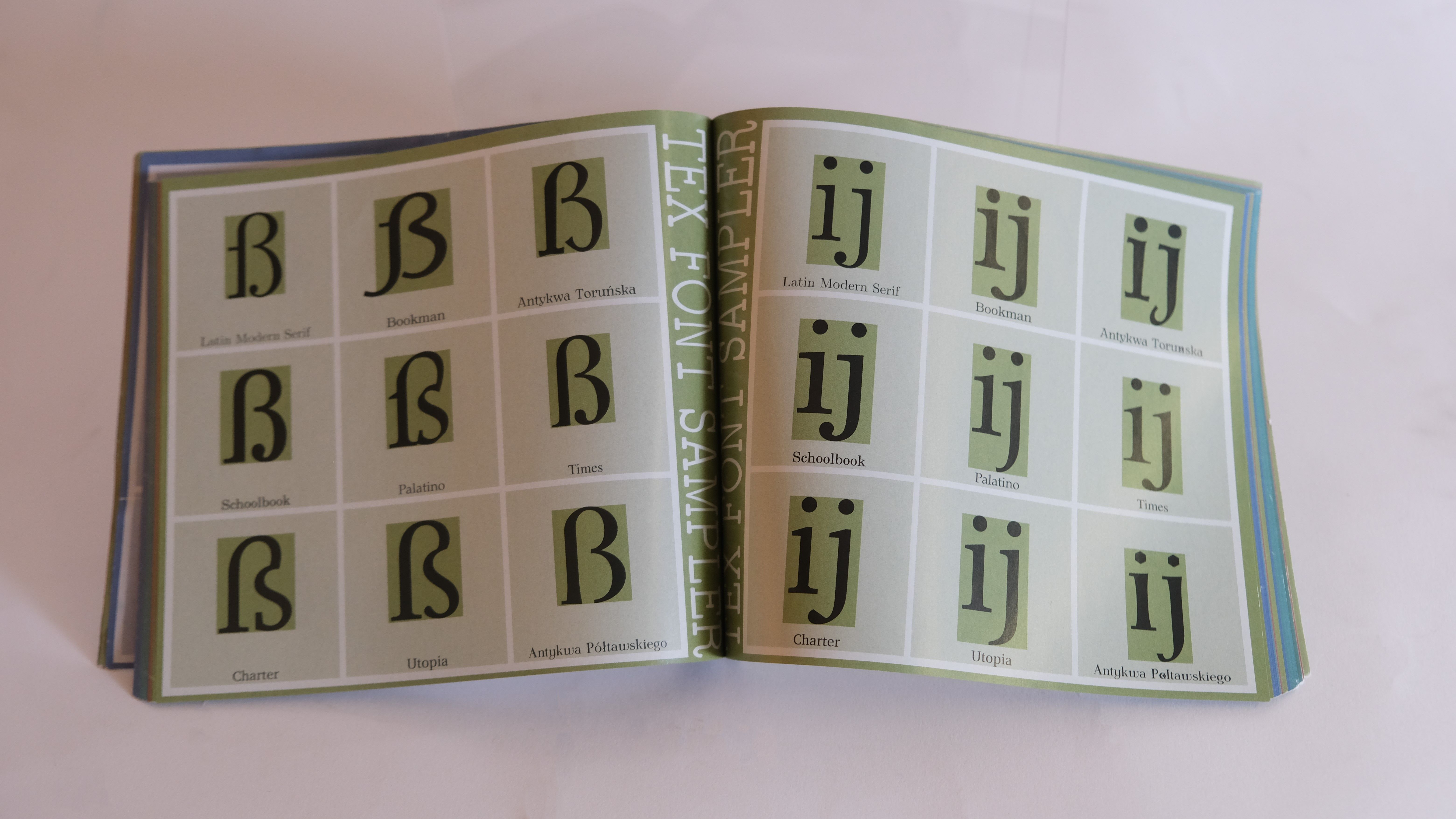

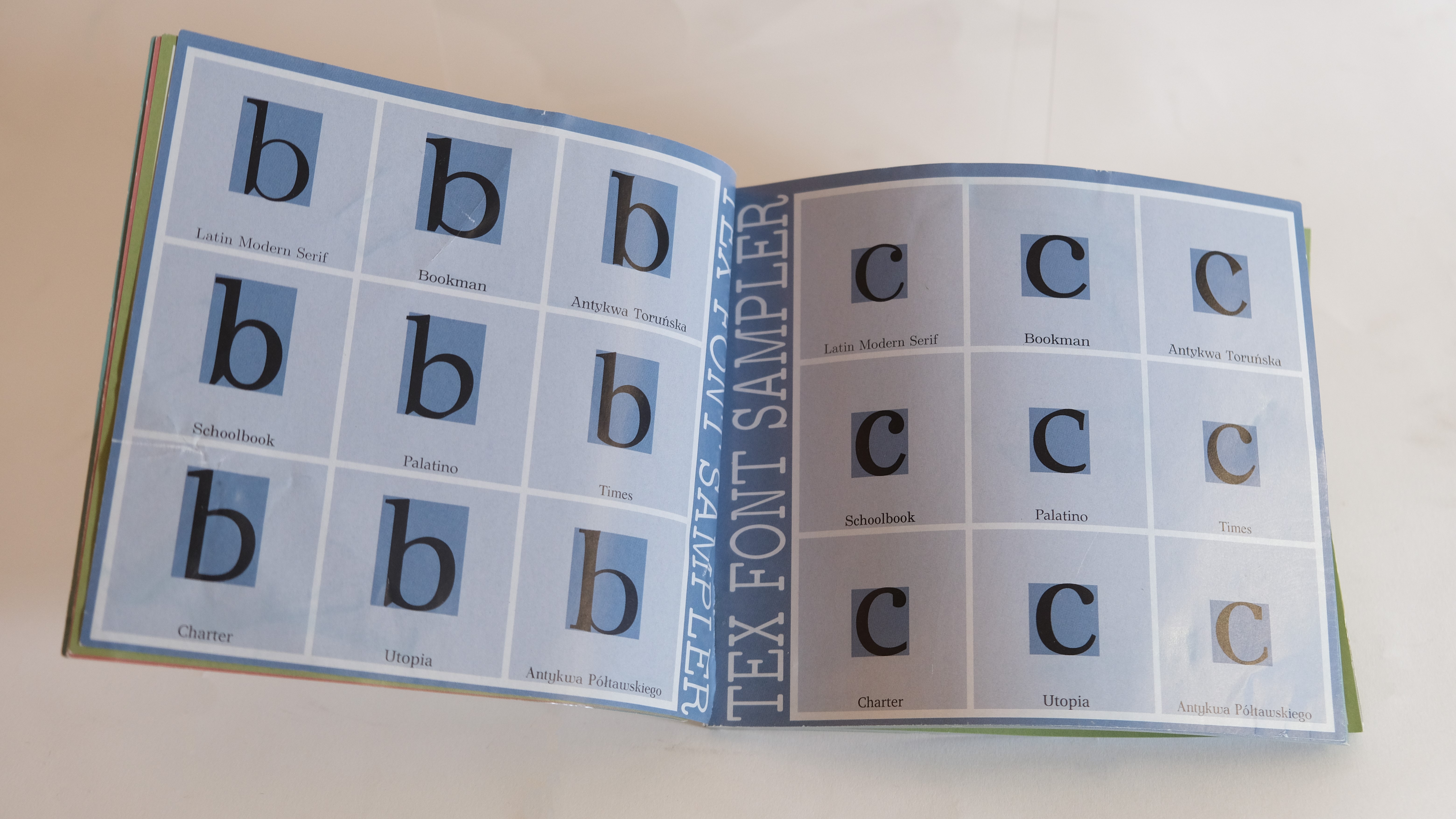

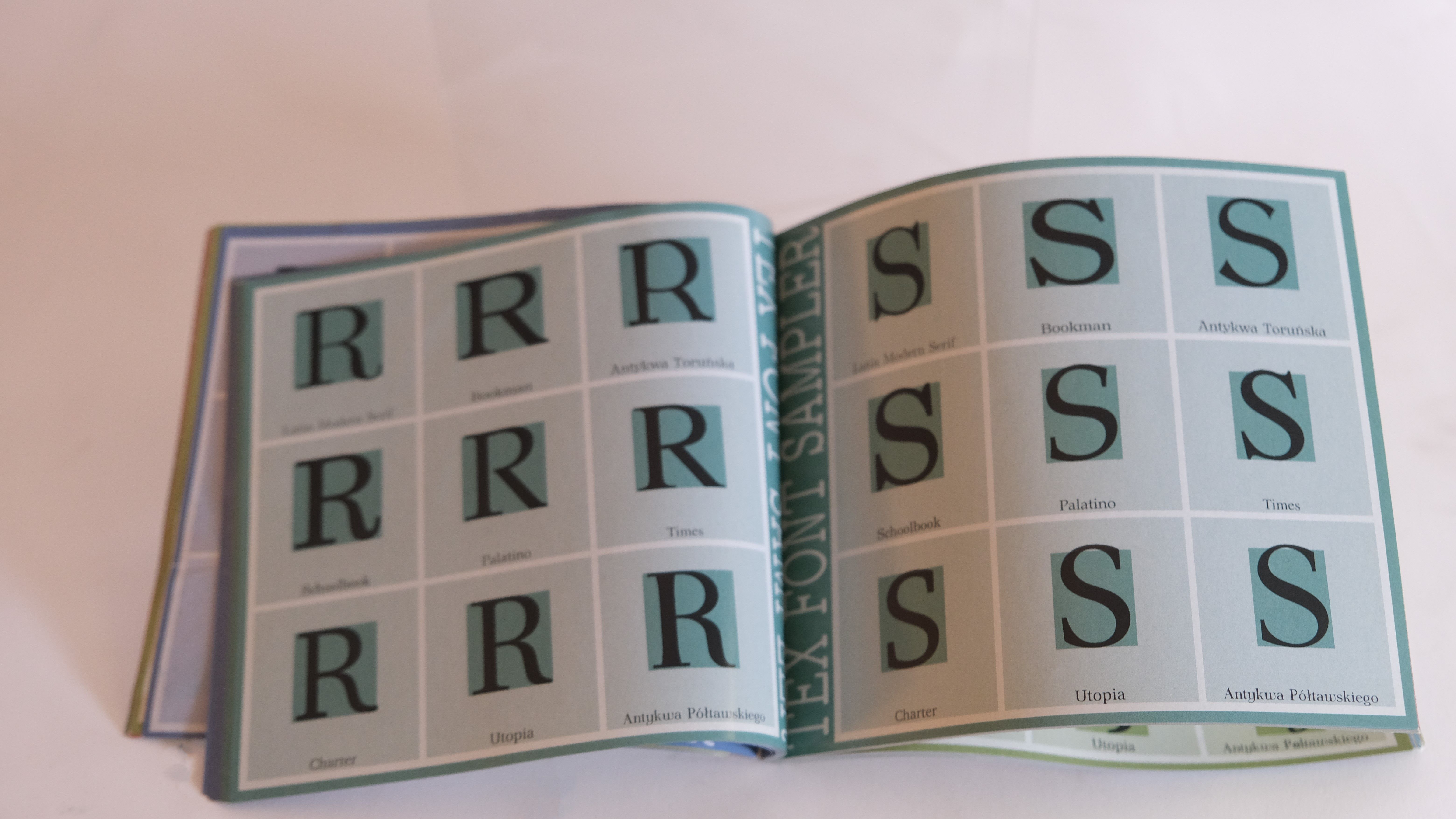

Tex Fonts Sample

Ce livre montre les de polices de texte prises en compte dans LaTeX un langage utilisée pour écrire des documents scientifiques entre autres.

UltraSPARC IIi

L'UltraSPARC IIi est un microprocesseur conçu par Sun Microsystems et est une version entrée de gamme de la famille des processeurs UltraSPARC qui possèdent l'architecture SPARC. Il a été introduit sur le marché en 1997 et a été largement utilisé dans les ordinateurs personnels et les stations de travail Sun. Le microprocesseur est le cœur des ordinateurs. Il est composé d'un circuit intégré, ou puce. Il permet d'effectuer des calculs complexes, de stocker des informations, de gérer et de transmettre des instructions.

L'UltraSPARC III est basé sur une architecture SPARC (Scalable Processor Architecture) et dispose d'un jeu d'instructions de 64 bits. Il utilise une architecture superscalaire, ce qui signifie qu'il peut exécuter plusieurs instructions simultanément pour améliorer les performances. Il possède également une vitesse d'horloge allant de 600 MHz à 900 MHz. Plus tard, d'autres versions améliorée pouvait même aller jusqu'à 1,2 GHz. Il est conçu pour fonctionner en configuration multiprocesseur, ce qui signifie qu'il peut être utilisé dans des systèmes comportant plusieurs processeurs travaillant ensemble pour exécuter des tâches de manière simultanée et parallèle. Cette capacité permet d'améliorer les performances des applications multitâches et des charges de travail intensives.

Il a joué un rôle clé dans l'évolution des architectures de processeurs SPARC et RISC (Reduced Instruction Set Computer), qui ont fortement influencé l'architecture ARM toujours utilisée avec par exemple la puce Apple M1 et Apple M2. Il a également a contribué à l'essor des systèmes Sun dans le domaine des serveurs et des stations de travail.

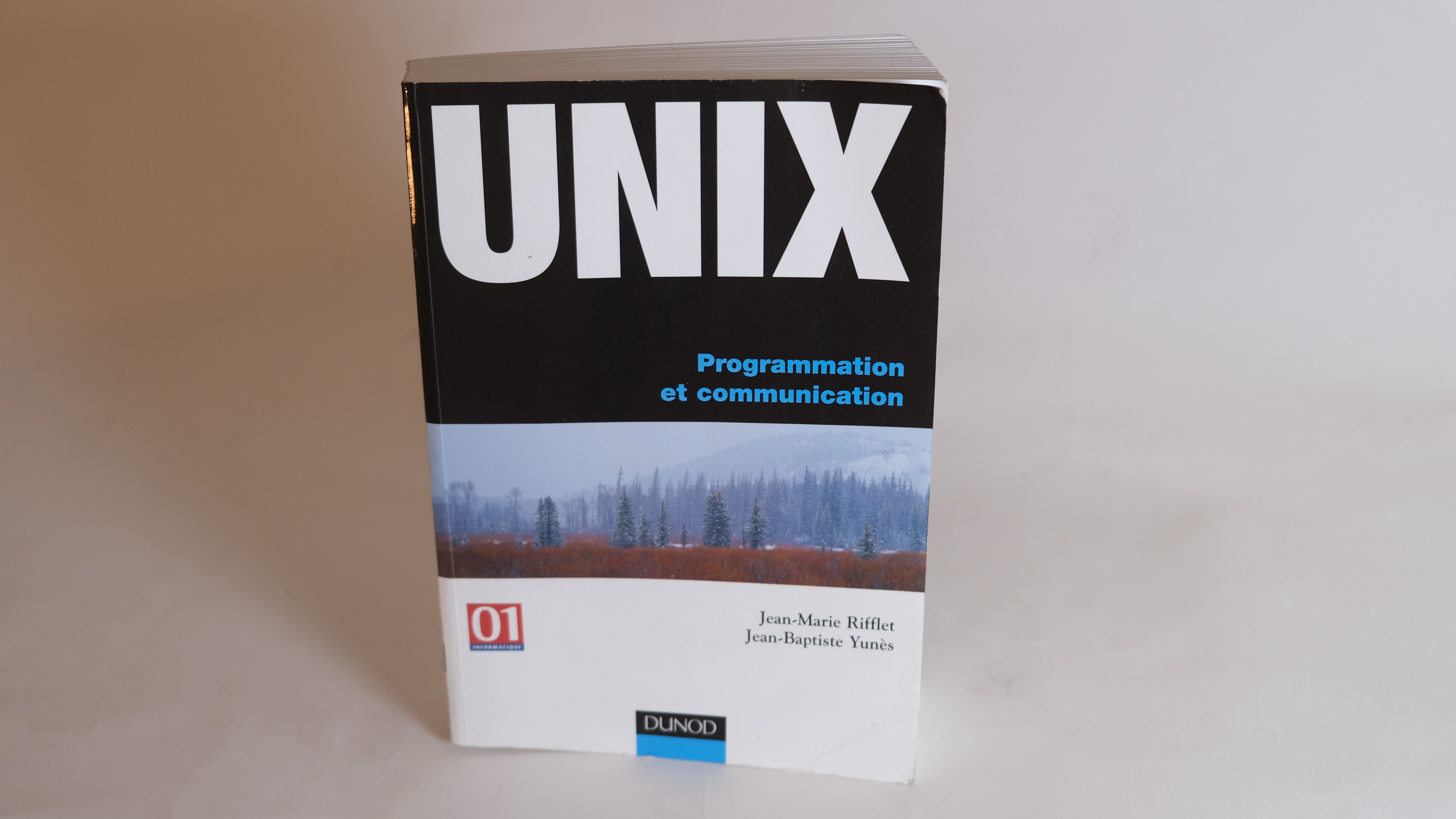

UNIX, Programmation et Communication

Conçu comme un guide de programmation système, cet ouvrage présente également une étude approfondie des mécanismes internes d'UNIX. Illustré par de nombreux exemples, il aborde successivement quatre aspects qui permettent au lecteur de progresser dans l'univers d'UNIX :

- L'environnement UNIX avec les principales commandes, les interpréteurs de langages de commandes, les éditeurs de texte et la communication entre systèmes.

- L'interface de programmation (API) entre les applications et le système ainsi que des aspects temps-réel.

- Les applications réparties et leur développement avec une présentation des concepts essentiels relatifs aux réseaux, à Internet et ses protocoles ainsi qu'aux éléments permettant l'implantation d'applications réparties communiquant par sockets ou par appels de procédures distantes.

UNIX Administration : Systèmes et Réseaux

Cet ouvrage présente UNIX du point de vue de l'administrateur système. Il traite successivement de l'administration système, de l'administration réseau et de quelques services indispensables (gestionnaire d'impression, courrier électronique, statistiques, etc.).

Le parti pris de l'auteur est d'amener de façon naturelle les raisons qui président l'utilisation d'une commande et les conséquences de son exécution, en expliquant les phénomènes qui la rendent nécessaire. Cette approche devrait amener à une meilleure compréhension de son des problèmes d'administration et surtout à aboutir plus simplement à leur résolution.

- Jean-Michel Moreno